Учени разработиха софтуер, който позволява изключително лесното създаване на "дийп фейк" видеа

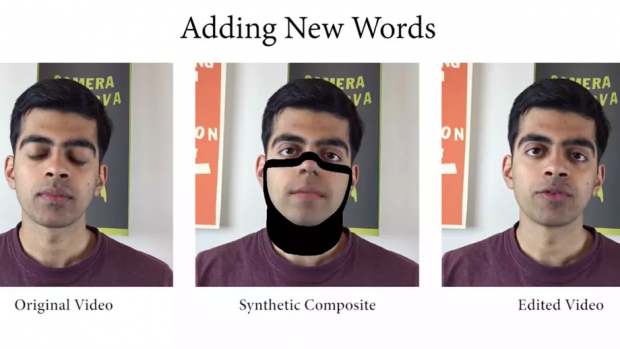

В най-новия пример на "дийп фейк" технологията, учени показаха нов софтуер, който използва машинно обучение, за да позволи на потребителите да редактират, добавят, изтрият или напълно да променят думите, които излизат от устата на някого в дадено видео, чрез въвеждане на новата дума или изречение.

Софтуерът е разработен от учени от Станфордския университет, Института по информатика „Макс Планк“, Принстънския университет и Adobe Research и показа, че способността ни да редактираме това, което хората казват във видеоклипове и да създават реалистични фалшификати, става все по-лесно с всеки изминал ден.

Този софтуер все още е на етап проучване и не е достъпен публично, но вероятно няма да отнеме много дълго, докато подобни услуги станат публични. Adobe например, вече сподели подробности за прототипния си софтуер "VoCo", който позволява на потребителите да редактират речи във видеа.

Интересното е, че при тестовете, в които фалшиви видеоклипове са били показани на група от 138 доброволци, около 60% от участниците са сметнали, че те се са реални. Това може да звучи доста ниско, но само 80% от същата група са сметнали, че оригиналните, нередактирани кадри са истински.

Както винаги обаче, важно е да помним, че има и ограничения относно това, което тази технология може да постигне за момента.

При този софтуер например, алгоритмите работят само върху видеоклипове в които на фокус и на преден план е глава на човек, като също така изискват 40 минути входни данни.

Редактираната реч също не изглежда, че може да се различава твърде много от изходния материал, защото за най-добрите си фалшификати, учените поискали от участниците във видеото да запишат нови речи, които да съответстват на промените.

Изследователите също така отбелязват, че те все още не могат да променят настроението или тона на гласа на говорещия, тъй като това би довело до "необичайни резултати" и че всякакви закривания на лицето, например ако някой размахва ръцете си докато говори, напълно ще объркат алгоритъма.

Както сами може да се досетите, в момента технологията не е перфектна, но това е неизбежно и е почти гарантирано, че тези лимитации ще бъдат преодолени с течение на времето.

Това означава, че обществото в най-скоро време ще трябва да се справи с основното нещо, което този софтуер ни показва – в даден момент от близкото бъдеще, всеки, дори и без техническо обучение, ще бъде способен да редактира това, което се казва в даден видеоклип.

Потенциалните вреди от тази технология са силно обезпокоителни и учените от тази област често са критикувани за това, че не вземат под внимание потенциалната злоупотреба с такъв софтуер.

Учените, участващи в този конкретен проект, казват, че са взели предвид тези проблеми.

„Въпреки че методите за манипулиране на изображения и видеа са толкова стари и развити, колкото самите медии, рисковете от злоупотреба се увеличават, когато такъв софтуер се използва за начин на комуникация, която би се зачела за авторитетна.

Ние признаваме, че тези технологии наистина могат да се използват, за фалшифициране на лични изявления и накърняване на репутацията на известни личности", пишат те.

Решението, което те предлагат обаче, е слабо утешително.

Те твърдят, че за да се предотврати объркване, редактираните видеа трябва ясно да бъдат представени като такива или чрез използване на воден знак, или чрез контекст – например аудитория, която разбира, че гледат редактирано видео.

Проблемът е, че водните знаци лесно се премахват, а загубата на контекст е един от отличителните белези на онлайн медиите.

Фалшификатите също не трябва да бъдат безупречни, за да имат влияние, защото както знаем, много фалшиви статии могат лесно да бъдат развенчани с няколко минути проучване из интернет, но това не спира тяхното разпространение, особено в общности, които искат да повярват на лъжи, които отговарят на техните предубеждения.

Учените отбелязват, че подобна технология има много полезни приложения, особено във филмовата и телевизионната индустрия, защото ще позволява корекции на неправилно изговорени думи или изречения без снимане на нови кадри, а също така и да се създават дублажи на актьори, които говорят на различни езици.

Тези ползи обаче определено изглеждат незначителни в сравнение с потенциалните щети.

Макар и да има добър аргумент, че "дийп фейк" пропагандата не е толкова голяма заплаха, колкото мнозина вярват, че е, умопомрачителният напредък при технологии като тази все още е дълбоко тревожен.

Източник: The Verge

Коментари