Изкуственият интелект има нужда от човешки контрол, за да не стане оръжие. Това заяви президентът и заместник-председател на Microsoft Брад Смит в интервю за CNBC.

Пожарите в Гърция са опустошили по-голяма площ от град Ню Йорк

Коментар

„Смятам, че всяка технология, изобретявана някога има потенциала да се превърне както в инструмент, така и в оръжие. Трябва да гарантираме, че изкуственият интелект остава под контрола на човека. Независимо дали става въпрос за правителство, военни или друг вид организация, която мисли да го ползва за автоматизиране на критична инфраструктура, трябва да гарантираме, че имаме хора под контрол. Че можем да забавим нещата или да ги изключим."

Това казва експертът.

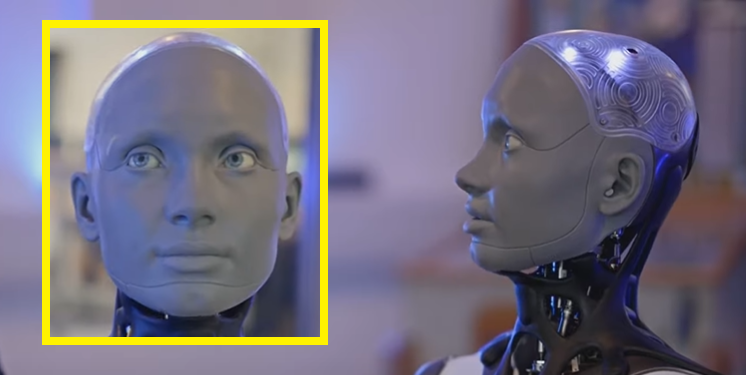

Технологични лидери от цял свят предупредиха за рисковете от изкуствения интелект. След като чатботът ChatGPT стана много популярен заради способността си да дава отговори, подобни на човешките. Генеративният ИИ е вид технология за изкуствен интелект, която може да генерира съдържание като текст, изображения, код и други.

Още гледни точки

Главният изпълнителен директор на OpenAI – компанията зад ChatGPT, Сам Алтман, заедно с ръководители на звеното за изкуствен интелект на Google DeepMind и Microsoft предупредиха през май, че изкуственият интелект представлява риск за изчезването на хората. И то равен на този от ядрената война и подчертаха необходимостта от намаляване на тези рискове.

Главният изпълнителен директор на Tesla Илън Мъск, съоснователят на Apple Стив Возняк и няколко технологични лидери също призоваха лабораториите за ИИ да спрат да обучават системи. Тези системи могат скоро да надминат GPT-4. Той е най-новият и усъвършенстван езиков модел на OpenAI. Те също така призоваха за 6-месечна пауза за такива напреднали разработки.

Източник: Калдата